Dentro un computer AI: perché i moderni sistemi di intelligenza artificiale consumano così tanta memoria

Com’è davvero un server AI quando si apre il coperchio

In questo periodo c’è molto rumore sul fatto che l’AI utilizzi “troppa memoria”. I prezzi sono in aumento. Le forniture sono limitate. Tutti dicono che la domanda stia esplodendo. Probabilmente lo hai già letto.

Ma gran parte di ciò che viene scritto salta la parte più importante: com’è fatto fisicamente un computer AI e perché ha bisogno di così tanta memoria in primo luogo. Non attraverso grafici astratti o previsioni di mercato, ma in termini che si possano visualizzare. Una volta compreso quanto consuma davvero un singolo sistema AI, il resto della storia smette di sembrare drammatico e inizia a sembrare inevitabile.

Mi sono ritrovato a spiegarlo di recente in un luogo che non ha nulla a che fare con i data center. Ero alla scuola di mio figlio per una “giornata dei genitori”, in piedi in un’aula, e alcuni studenti hanno iniziato a fare domande sull’AI. Non domande sui chatbot. Domande vere. Com’è fatto il computer? Dove vanno i dati? Perché tutti continuano a parlare di “memoria” come se fosse l’elemento chiave?

Così ho iniziato dalle basi. Ho chiesto loro di immaginare un computer normale. Uno che useresti a casa. Ha un processore che esegue i calcoli, una memoria che mantiene ciò su cui sta lavorando in quel momento e uno spazio di archiviazione che conserva le cose per dopo. Compiti. Foto. Giochi. Ogni cosa ha il suo posto.

Poi ho spiegato che l’AI è ancora un computer, ma non uno che esegue una sola piccola attività alla volta. Sta elaborando enormi quantità di calcoli su enormi quantità di dati, più e più volte, confrontando modelli, regolando pesi, salvando checkpoint, e lo fa così velocemente che l’attesa dello storage diventa il nemico principale.

È per questo che la memoria diventa la protagonista. Non perché sia di moda. Ma perché senza memoria sufficiente e storage veloce, le GPU restano in attesa, ed è come comprare un’auto da corsa e lasciarla parcheggiata perché la strada è troppo stretta.

Un server AI non è un singolo tower desktop. È più simile a una workstation estremamente compatta portata all’estremo. Un tipico server di addestramento oggi ha otto GPU, e ogni GPU dispone della propria memoria ultra-veloce solo per tenere il passo con i calcoli. Oltre a questo, il server ha un ampio pool di memoria di sistema per alimentare le GPU senza colli di bottiglia, e poi una serie di SSD NVMe all’interno del telaio per preparare i dataset e scrivere i risultati intermedi.

Quando si guarda una distinta base reale di una di queste macchine, non c’è nulla di discreto. Si parla di centinaia di gigabyte di memoria GPU, spesso da mezzo terabyte a diversi terabyte di RAM di sistema, e di decine di terabyte di storage NVMe SSD all’interno di un singolo server. Non sulla rete. Non in un SAN condiviso. Dentro una sola unità.

Di solito è il momento in cui la stanza si fa silenziosa, perché la scala diventa reale. Un solo server può contenere più memoria flash di quanta ne possiedano la maggior parte delle famiglie. E l’AI non scala aggiungendo un server e fermandosi lì. Scala aggiungendone decine o centinaia alla volta, perché l’addestramento di modelli di grandi dimensioni è un lavoro di squadra. Una singola macchina non regge tutto il carico.

Quindi, se un singolo server AI consuma silenziosamente venti o trenta terabyte di flash, cosa succede quando se ne distribuiscono cento? Si parla improvvisamente di petabyte di NAND flash consumati in un’unica espansione, e questo prima ancora di considerare sistemi di storage condivisi, replica, backup, logging e gli aggiornamenti “ci serve più veloce rispetto all’ultimo trimestre” che iniziano non appena il cluster entra in produzione.

È qui che le storie sulla carenza di memoria smettono di sembrare hype e iniziano a sembrare semplice aritmetica. Le fabbriche di memoria non nascono dall’oggi al domani. Flash e DRAM richiedono anni per pianificazione, costruzione, qualificazione e avviamento. Anche quando i titoli parlano di fluttuazioni dei prezzi della memoria, i limiti strutturali dell’offerta non scompaiono quando la domanda arriva in blocchi delle dimensioni di un data center.

Poi arriva la seconda ondata: i sistemi su scala di rack. Invece di trattare ogni server come una macchina indipendente, i produttori oggi costruiscono interi rack che si comportano come un singolo computer. Decine di GPU in un rack, enormi pool di memoria, file di SSD allineati uno accanto all’altro. Le distanze si misurano in centimetri, non in metri, perché la velocità conta enormemente.

A quel punto non ci si chiede più: “Quanta memoria serve a un computer?”. La domanda diventa: “Quanta memoria serve a un rack?”. Ed è esattamente per questo che l’elettronica di consumo sente la pressione. Non perché i consumatori abbiano improvvisamente iniziato a comprare il doppio degli smartphone, ma perché è arrivato un acquirente diverso, con una scala di domanda completamente differente, che acquista in blocchi simili a interi data center.

A livello di storage, questo spiega anche perché ipotesi di lunga data sul comportamento della memoria flash stiano venendo meno. Quando i carichi di lavoro AI dominano la domanda, distinzioni come MLC rispetto a TLC NAND smettono di essere accademiche e iniziano a influenzare in modo molto concreto disponibilità, durata e decisioni di allocazione.

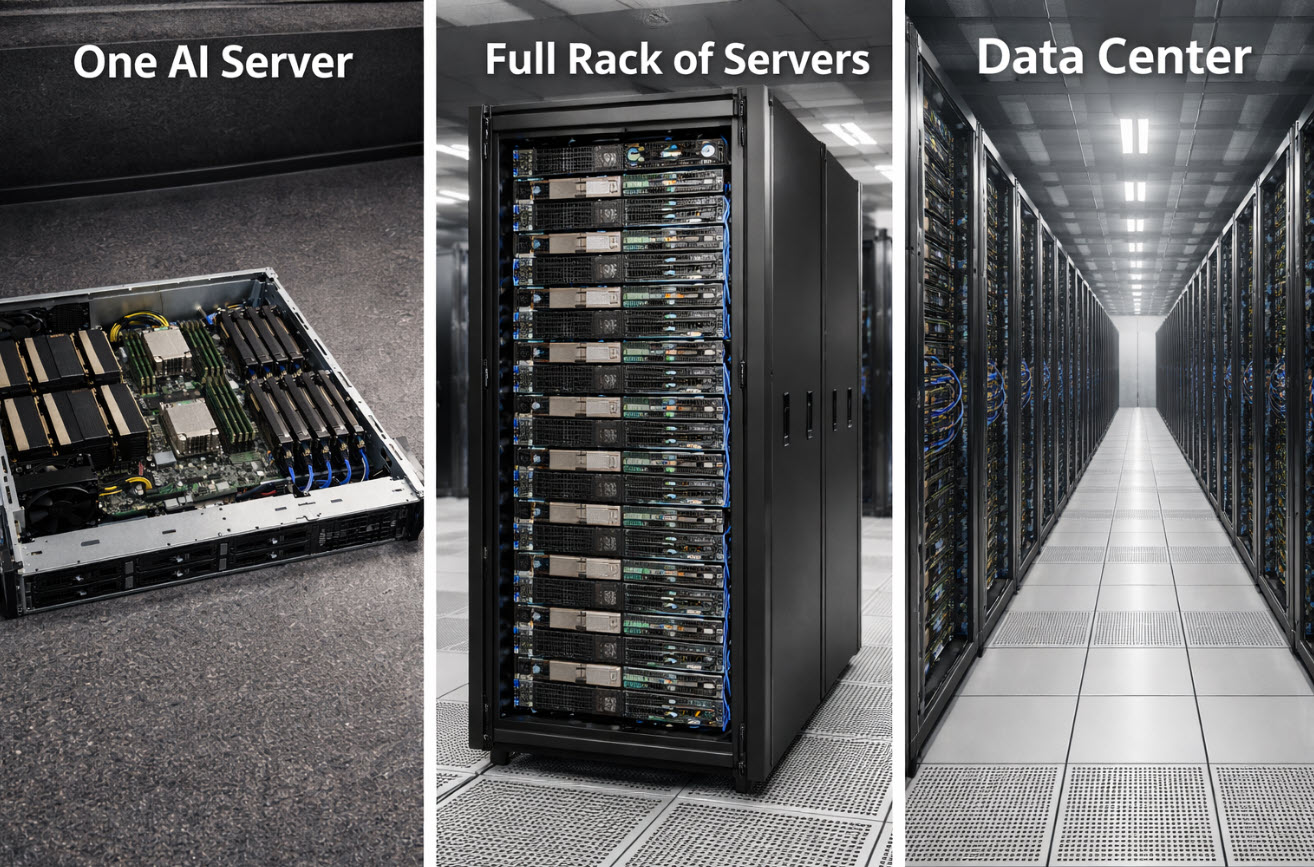

I ragazzi non avevano bisogno di una lezione sulla supply chain per capirlo. Avevano solo bisogno dell’immagine. Una unità diventa una fila. Una fila diventa un rack. Un rack diventa una stanza. Una stanza diventa un edificio. Quando si vede l’AI come infrastruttura, e non come magia, la storia della memoria diventa fisica, meccanica e prevedibile.

Ed è questo il punto. Non si tratta di una carenza misteriosa. È una collisione prevedibile tra capacità che richiedono anni per essere costruite e una domanda che può apparire dall’oggi al domani sotto forma di alcuni camion di server diretti verso un edificio grande come un magazzino.

In poche parole: l’AI non sta solo usando più memoria di prima. Sta ridefinendo cosa significhi davvero una quantità “normale” di memoria.

Come è stato creato questo articolo

Biografia dell’autore sotto — Specialista in sistemi di storage USB e duplicazione

Questo articolo è stato redatto con il supporto dell’intelligenza artificiale per la struttura e le formulazioni, quindi rivisto, modificato e finalizzato da un autore umano per migliorare chiarezza, accuratezza e rilevanza pratica.

Informativa sull’immagine

L’immagine all’inizio di questo articolo è stata generata utilizzando l’intelligenza artificiale a scopo illustrativo. Non è una fotografia di ambienti reali.

Tags: carenza di memoria, data center, domanda di SSD, Infrastruttura AI, NAND flash

Trackback dal tuo sito.